Es ist wichtig, Ihre Website ständig zu aktualisieren, um sie sauber und auf dem neuesten Stand zu halten und ihre Leistung in den Suchmaschinen zu verbessern. Allerdings kann die Überprüfung jeder einzelnen Seite Ihrer Website eine komplizierte Aufgabe sein.

In der digitalen Welt des Internets wird die Rolle von Web-Crawlern daher wichtiger denn je. Ein Web-Crawler ist ein Bot, der Ihre Website digital durchsucht und dabei hilft, Webseiten zu indizieren, Daten zu sammeln und Suchmaschinen in die Lage zu versetzen, hochwertige Ergebnisse zu liefern.

Das Verständnis der verschiedenen Arten von Web-Crawlern und ihrer Funktionen kann wertvolle Einblicke in die Optimierung Ihrer Website bieten und Ihnen helfen, im SEO-Spiel ganz vorne zu bleiben. Deshalb stellen wir heute eine umfassende Crawler-Liste vor, die für Webmaster und SEO-Profis da draußen hilfreich sein kann.

Inhalt

Umschalten aufWeb Crawler verstehen

Web-Crawler, auch Web-Crawler-Bots genannt, sind automatisierte Programme, die sich im Web hin und her bewegen und Inhalte für die Suchmaschinenoptimierung, Datenerfassung und Überwachung organisieren.

Sie sind für die Indexierung von Webseiten unerlässlich, da Suchmaschinen wie Google, Bing und andere ein User-Agent-Token verwenden, um sich beim Zugriff auf Websites zu identifizieren.

Wenn Sie die Funktionsweise der verschiedenen Webcrawler anhand einer umfassenden Liste verstehen, können Sie Ihre Landing Pages für Suchmaschinen optimieren.

Lesen Sie mehr: Was ist ein Web Crawler?

Wie Web Crawler funktionieren

Web-Crawler scannen systematisch Webseiten und indizieren die Daten, um sie im Index einer Suchmaschine zu speichern, damit sie bei Suchanfragen von Benutzern abgerufen werden können. Es folgt Links von einer Seite zur anderen und hält sich an das robots.txt-Protokoll, damit die Crawler der Suchmaschinen wissen, auf welche URLs der Crawler auf Ihrer Website zugreifen kann.

Entwickler oder Vermarkter können in ihrer robots.txt auf ihrer Website angeben, ob sie bestimmte Crawler auf der Grundlage ihres User-Agent-Tokens zulassen oder ablehnen.

Wenn Sie den Crawling-Prozess verstehen, können Sie Ihre Website für Suchmaschinen wie Google und Bing besser zugänglich und sichtbar machen. Dieses Wissen kann letztendlich das Ranking und die Sichtbarkeit Ihrer Website in den Suchergebnissen verbessern.

Arten von Web Crawlern

Es gibt drei Haupttypen von Webcrawlern:

- Allgemeine Crawler, auch Webcrawler oder Spider genannt, durchsuchen systematisch Webseiten, um Daten für die Indizierung durch Suchmaschinen zu sammeln. Suchmaschinen verwenden diese Informationen, um Suchergebnisse zu bewerten und zu präsentieren.

- Fokussierte Crawler sind auf bestimmte Arten von Inhalten oder Websites ausgerichtet. Sie sind darauf ausgelegt, Informationen zu einem bestimmten Thema oder Bereich zu sammeln.

- Inkrementelle Crawler crawlen nur Webseiten, die seit dem letzten Crawlen aktualisiert wurden. So können sie neue oder geänderte Inhalte effizient erfassen, ohne die gesamte Website neu zu crawlen.

Fokussierte Crawler hingegen sammeln Webseiten, die einer bestimmten Eigenschaft oder einem bestimmten Thema entsprechen, wobei sie die Crawling-Grenze strategisch priorisieren und eine Sammlung relevanter Seiten anlegen.

Inkrementelle Crawler besuchen URLs erneut und crawlen bestehende URLs erneut, um die gecrawlten Daten auf dem neuesten Stand zu halten, was sie ideal für Szenarien macht, die aktuelle und konsistente Daten erfordern.

Verwandt: Wie funktioniert eine Suchmaschine - Crawling, Indexierung und Ranking?

Top 14 Web Crawler Liste zu wissen, im Jahr 2023

In dieser umfassenden Crawler-Liste werden die gängigsten Web-Crawler aufgeführt und ihre Rolle bei der Indizierung, Datenerfassung und Analyse von Suchmaschinen hervorgehoben. Diese Crawler umfassen:

- Googlebot

- Bingbot

- Yandex Bot

- Google Bard

- Openai ChatGPT

- Facebook Crawler

- Twitterbot

- Pinterestbot

- AhrefsBot

- SemrushBot

- Mozs Kampagnen-Crawler Rogerbot

- Apache Nutch

- Der schreiende Frosch

- HTTrack

In der Crawler-Liste werden wir uns mit jedem dieser Programme befassen, wobei wir uns auf ihre besonderen Aufgaben und Funktionen konzentrieren.

Googlebot

Googlebot, auch bekannt als User Agent Googlebot, ist der primäre Web-Crawler für Google. Er ist für die Indizierung und das Rendern von Seiten für die Suchmaschine verantwortlich. Er durchforstet Google-Websites, indem er Links folgt, Webseiten scannt und die robots.txt-Regeln befolgt, um sicherzustellen, dass der Inhalt der Website für die Google-Suchmaschine zugänglich ist.

Es ist wichtig, mit dem Googlebot vertraut zu sein, da sein Crawling-Prozess das Suchmaschinen-Ranking und die Sichtbarkeit Ihrer Website deutlich verbessern kann.

Bingbot

Bingbot ist Microsofts Web-Crawler für die Bing-Suchmaschine mit einem Mobile-First-Ansatz für die Indizierung. Er konzentriert sich auf die Indizierung der mobilen Version von Websites und hebt mobilfreundliche Inhalte in den Suchergebnissen hervor, um dem mobilen Charakter des modernen Surfens gerecht zu werden.

Er ähnelt dem Googlebot, und die führende chinesische Suchmaschine ist ein wichtiger Crawler für alle, die ihre Inhalte in mehreren Suchmaschinen auffindbar machen wollen.

Yandex Bot

Yandex Bot ist der Web-Crawler für die russische Suchmaschine Yandex, der kyrillische Schrift und russischsprachige Inhalte bevorzugt. Er ist für das Crawling und die Indizierung von Websites zuständig, die überwiegend in russischer Sprache verfasst sind, und geht auf die besonderen Bedürfnisse des russischsprachigen Publikums ein.

Yandex Bot ist ein wichtiger Web-Crawler für diejenigen, die auf den russischen Markt abzielen, um ihre Inhalte zu optimieren.

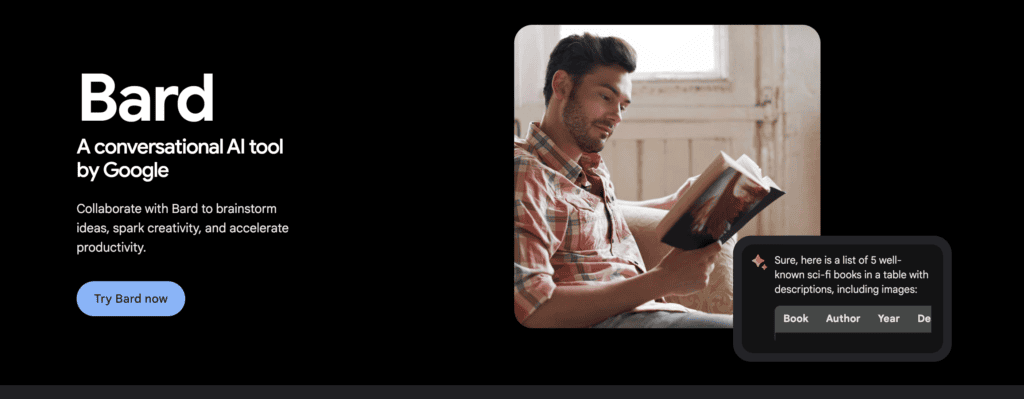

Google Bard

Google Bard ist ein Web-Crawler für die generativen APIs Bard und Vertex von Google und hilft Web-Publishern bei der Verwaltung von Website-Verbesserungen. Es kann Web-Publishern bei der Verwaltung von Website-Verbesserungen helfen, indem es präzisere Antworten bietet, mit Google-Apps und -Diensten integriert wird und es Publishern ermöglicht, KI-Trainingsdaten zu regulieren.

Es verbessert die Sichtbarkeit von Quellinhalten und liefert echte Zitate in Antworten, was es zu einem wertvollen Werkzeug für Web-Publisher macht, die ihre Inhalte optimieren wollen.

Openai ChatGPT

Openai ChatGPT ist ein Web-Crawler, der von OpenAI für das Training und die Verbesserung seiner Sprachmodelle verwendet wird. GPTBot sammelt öffentlich verfügbare Daten von Websites, um Modelle der künstlichen Intelligenz wie GPT-4 zu verbessern.

Der Web-Crawler von Openai ChatGPT verfeinert die KI-Fähigkeiten erheblich, was zu einem besseren Benutzererlebnis und genaueren Antworten des KI-gesteuerten Chatbots führt.

Crawler für soziale Medien

Crawler für soziale Medien verbessern die Nutzererfahrung und das Engagement auf verschiedenen Plattformen. Sie indizieren und zeigen geteilte Inhalte auf Plattformen wie Facebook, Twitter und Pinterest an und bieten den Nutzern eine visuell ansprechende und informative Vorschau von Webinhalten.

Wir werden nun drei bemerkenswerte Social Media Crawler besprechen: Facebook Crawler, Twitterbot und Pinterestbot.

Facebook Crawler

Facebook Crawler sammelt Website-Informationen, die auf der Plattform geteilt werden, und generiert umfangreiche Vorschauen, einschließlich eines Titels, einer kurzen Beschreibung und eines Miniaturbilds. So können Nutzer einen kurzen Blick auf den geteilten Inhalt werfen, bevor sie auf den Link klicken, was die Nutzererfahrung verbessert und die Beschäftigung mit dem geteilten Inhalt fördert.

Facebook Crawler optimiert die geteilten Inhalte für die Plattform und bietet den Nutzern ein visuell ansprechendes und informatives Browsing-Erlebnis.

Twitterbot

Twitterbot, der Web-Crawler von Twitter, indiziert und zeigt freigegebene URLs an, um eine Vorschau von Webinhalten auf der Plattform anzuzeigen. Durch die Erstellung von Vorschaukarten mit Titeln, Beschreibungen und Bildern bietet Twitterbot den Nutzern eine Momentaufnahme der geteilten Inhalte und fördert so das Engagement und die Interaktion der Nutzer.

Twitterbot optimiert Inhalte für die Twitter-Plattform und erleichtert es den Nutzern, geteilte Inhalte zu entdecken und mit ihnen zu interagieren.

Pinterestbot

Es ist ein Web-Crawler für die visuell orientierte soziale Plattform, der sich auf die Indizierung von Bildern und Inhalten für die Anzeige auf der Plattform konzentriert. Pinterestbot crawlt und indiziert Bilder und ermöglicht es Nutzern, visuelle Inspirationen durch Pins und Boards zu entdecken und zu speichern.

Seine Hauptfunktion besteht darin, den Nutzern ein visuell beeindruckendes und organisiertes Browsing-Erlebnis zu bieten, das es ihnen ermöglicht, auf ihre Interessen zugeschnittene Inhalte zu erkunden und sich mit ihnen zu beschäftigen.

SEO Tool Crawler Liste

SEO-Tool-Crawler sind unverzichtbar für die Sammlung von Daten zur Analyse und Optimierung der Website-Performance in verschiedenen SEO-Plattformen. Diese Crawler bieten wertvolle Einblicke in die Website-Struktur, Backlinks und Nutzerbindung und helfen Website-Besitzern und Vermarktern, fundierte Entscheidungen zur Verbesserung ihrer Online-Präsenz zu treffen.

Wir werden nun drei beliebte SEO-Tool-Crawler untersuchen: AhrefsBot, SemrushBot und Moz' Campaign Crawler Rogerbot.

AhrefsBot

AhrefsBot ist ein Web-Crawler, der Links für die Ahrefs SEO-Software indiziert. Er besucht täglich 6 Milliarden Websites und ist damit nach dem Googlebot der zweitaktivste Crawler.

AhrefsBot durchforstet Websites, um Informationen über Backlinks, Keywords und andere SEO-Faktoren zu sammeln. Es wird verwendet, um Optimierungsentscheidungen zu treffen.

AhrefsBot ist ein wertvolles Tool für alle, die das Suchmaschinen-Ranking und die Sichtbarkeit ihrer Website verbessern wollen. Dazu gehören auch Website-Besitzer, SEO-Profis und Vermarkter.

SemrushBot

SemrushBot ist ein Web-Crawler-Bot, der von Semrush, einem führenden SEO-Softwareanbieter, eingesetzt wird. Er sammelt und katalogisiert Website-Daten für die Nutzung durch seine Kunden auf seiner Plattform. Er erstellt eine Liste von Webseiten-URLs, besucht sie und speichert bestimmte Hyperlinks für zukünftige Besuche.

Die Daten von SemrushBot werden in mehreren Semrush-Tools verwendet, darunter:

- Öffentliche Backlink-Suchmaschine

- Website-Audit-Tool

- Backlink-Audit-Tool

- Werkzeug zum Linkaufbau

- Schreibassistentin

Diese Tools liefern wertvolle Erkenntnisse zur Optimierung der Website-Leistung und der SEO-Strategien.

Mozs Kampagnen-Crawler Rogerbot

Moz's Campaign Crawler Rogerbot ist ein Webcrawler, der speziell für Moz Pro Campaign Site Audits entwickelt wurde. Er wird von der führenden SEO-Website Moz bereitgestellt. Er sammelt Inhalte für Moz Pro Campaign-Audits und befolgt die robots.txt-Regeln, um die Einhaltung der Präferenzen des Website-Besitzers sicherzustellen.

Rogerbot ist ein wertvolles Werkzeug für Website-Besitzer und Vermarkter, die das Suchmaschinen-Ranking und die Sichtbarkeit ihrer Website verbessern wollen. Es verwendet umfassende Website-Audits und datengesteuerte Optimierungsstrategien.

Verwandt: Optimale SEO auf WordPress im Jahr 2024: Ein umfassender Leitfaden

Open Source Crawler

Open-Source-Crawler bieten Flexibilität und Skalierbarkeit für das Crawlen bestimmter Websites oder für das Crawlen großer Internetmengen. Diese Crawler können an spezifische Anforderungen angepasst werden. Das macht sie zu einer wertvollen Ressource für Webentwickler und SEO-Experten, die die Leistung ihrer Website optimieren möchten.

Wir werden nun drei Open-Source-Crawler genauer unter die Lupe nehmen: Apache Nutch, Screaming Frog und HTTrack.

Apache Nutch

- ein flexibler und skalierbarer Open-Source-Webcrawler

- für das Crawlen bestimmter Websites oder des gesamten Internets

- basierend auf Apache Hadoop Datenstrukturen

- können detailliert konfiguriert werden.

Apache Nutch ist ideal für Webentwickler und SEO-Profis, die einen anpassbaren Web-Crawler für ihre speziellen Anforderungen benötigen, sei es für das Crawlen einer bestimmten Website oder für die Durchführung umfangreicher Internet-Crawls.

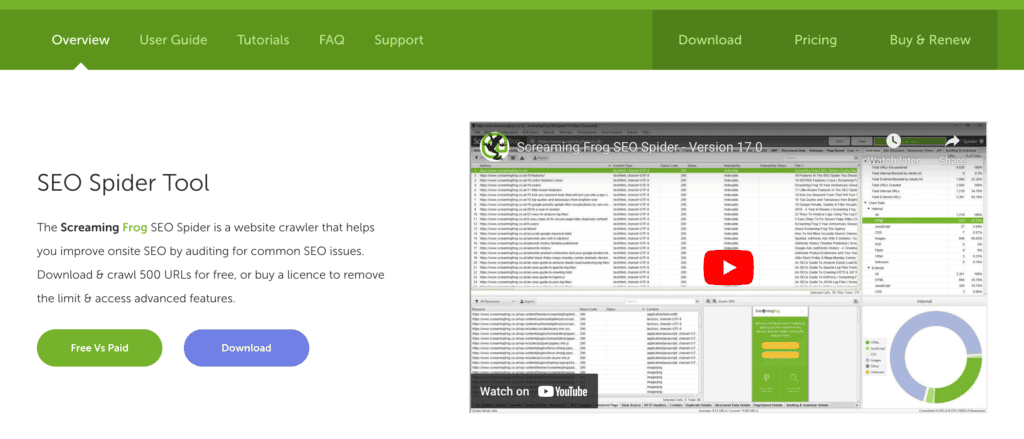

Der schreiende Frosch

Screaming Frog ist ein Desktop-Tool für das Crawling von Websites aus der SEO-Perspektive, das Onsite-Elemente in Tabs zur Echtzeit-Analyse und Filterung darstellt. Es ist bekannt für seine benutzerfreundliche Oberfläche und seine Schnelligkeit bei der Erstellung technischer Ergebnisse, die die Google-Crawls maximieren.

Screaming Frog ist eine unverzichtbare Ressource für Webentwickler und SEO-Profis, die die Leistung ihrer Website mit umfassenden Site-Audits und datengesteuerten Optimierungsstrategien verbessern wollen.

HTTrack

HTTrack ist eine Freeware, die Websites herunterladen und spiegeln kann, mit Unterstützung für mehrere Systeme und vielen Funktionen. Es arbeitet mit einem Web-Crawler, um die Dateien der Website abzurufen und sie in einer Struktur zu organisieren, die die relative Linkstruktur der ursprünglichen Website beibehält.

Dies ermöglicht es den Nutzern, die heruntergeladene Website mit einem beliebigen Webbrowser offline zu durchsuchen. HTTrack ist ein wertvolles Werkzeug für Website-Besitzer und -Vermarkter, die eine lokale Kopie einer Website zum Offline-Surfen oder für Replikationszwecke erstellen möchten.

Schutz Ihrer Website vor bösartigen Crawlern

Der Schutz Ihrer Website vor bösartigen Crawlern ist wichtig, um Betrug, Angriffe und Informationsdiebstahl zu verhindern. Das Erkennen und Blockieren dieser schädlichen Crawler kann den Inhalt Ihrer Website, die Nutzerdaten und die Online-Präsenz schützen. Dadurch wird das Surfen Ihrer Besucher sicher und geschützt.

Wir werden nun Techniken zur Identifizierung bösartiger Crawler und Methoden zur Blockierung ihres Zugangs zu Ihrer Website erörtern.

Identifizierung bösartiger Crawler

Die Identifizierung bösartiger Crawler umfasst die Überprüfung von User-Agents, einschließlich der vollständigen User-Agent-Zeichenfolge, der User-Agent-Zeichenfolge für den Desktop, der User-Agent-Zeichenfolge und der IP-Adressen in Website-Einträgen.

Sie können zwischen legitimen und bösartigen Webcrawlern unterscheiden, indem Sie diese Merkmale analysieren. So können Sie geeignete Maßnahmen ergreifen, um Ihre Website vor potenziellen Bedrohungen zu schützen.

Die regelmäßige Überwachung der Zugriffsprotokolle Ihrer Website und die Umsetzung von Sicherheitsmaßnahmen können dazu beitragen, eine sichere Online-Umgebung für Ihre Nutzer zu gewährleisten.

Blockierungstechniken

Techniken wie die Anpassung von Berechtigungen mithilfe von robots.txt und der Einsatz von Sicherheitsmaßnahmen wie Web Application Firewalls (WAF) und Content Delivery Networks (CDN) können bösartige Crawler blockieren.

Die Verwendung der "Disallow"-Direktive, gefolgt vom User-Agent-Namen des Crawlers, den Sie in Ihrer robots.txt-Datei blockieren möchten, ist ein effektiver Weg, um bestimmte Webcrawler zu blockieren.

Darüber hinaus kann die Implementierung einer WAF eine Website vor bösartigen Crawlern schützen, indem der Datenverkehr gefiltert wird, bevor er die Website erreicht, während ein CDN eine Website vor bösartigen Crawlern schützen kann, indem es Anfragen an den Server weiterleitet, der dem Standort des Benutzers am nächsten ist, wodurch das Risiko von Bots, die die Website angreifen, verringert wird.

Die Anwendung dieser Blockierungstechniken kann dazu beitragen, Ihre Website vor schädlichen Crawlern zu schützen und ein sicheres Surferlebnis für Ihre Besucher zu gewährleisten.

Verwandt: Die besten WordPress-Sicherheitsdienstleister von 2023

Möchten Sie die SEO Ihrer Website verbessern?

Erhalten Sie alle Antworten mit einem detaillierten SEO-Audit Ihrer Website, um wieder in den Suchergebnissen zu erscheinen

Zusammenfassung

Zusammenfassend lässt sich sagen, dass Web-Crawler eine wichtige Rolle in der digitalen Landschaft spielen, da sie für die Indizierung von Webseiten und die Sammlung von Daten zuständig sind und es den Suchmaschinen ermöglichen, hochwertige Ergebnisse zu liefern.

Das Verständnis der verschiedenen Arten von Web-Crawlern und ihrer Funktionen kann Ihnen wertvolle Einblicke in die Optimierung Ihrer Website geben und Ihnen helfen, in der digitalen Welt die Nase vorn zu haben. Durch die Implementierung geeigneter Sicherheitsmaßnahmen und Blockierungstechniken können Sie Ihre Website vor bösartigen Crawlern schützen und eine sichere Online-Umgebung für Ihre Nutzer aufrechterhalten.

Häufig gestellte Fragen

Beispiele für Webcrawler sind Googlebot (Desktop- und mobile Versionen), Bingbot, DuckDuckBot, Yahoo Slurp, YandexBot, Baiduspider und ExaBot.

Eine Crawler-Suchmaschine, auch bekannt als Spider, Robot oder Bot, ist ein automatisiertes Programm, das systematisch Webseiten durchsucht, um sie für Suchmaschinen zu indizieren.

Crawler sind automatisierte Computerprogramme, die das Internet durchsuchen und oft auch als "Robots" bezeichnet werden. Verschiedene Crawler sind auf Web Scraping, Indexierung und Link Following spezialisiert. Sie verwenden diese Daten, um Webseiten für Suchergebnisse zusammenzustellen.

Crawler für soziale Medien helfen bei der Indizierung und Anzeige von Inhalten auf verschiedenen Plattformen und verbessern so die Benutzerfreundlichkeit und das Engagement.

Implementieren Sie Web Application Firewalls (WAF) und Content Delivery Networks (CDN), um Ihre Website vor bösartigen Crawlern zu schützen.