È importante aggiornare costantemente il vostro sito per mantenerlo pulito e aggiornato e migliorarne le prestazioni nei motori di ricerca. Tuttavia, rivedere ogni pagina del vostro sito può essere un compito complicato.

Per questo motivo, nello spazio web in continua evoluzione digitale, il ruolo dei web crawler sta diventando più significativo che mai. Un web crawler è un bot che esamina digitalmente il vostro sito web e aiuta a indicizzare le pagine web, a raccogliere dati e a consentire ai motori di ricerca di fornire risultati di qualità.

La comprensione dei diversi tipi di web crawler e delle loro funzioni può fornire indicazioni preziose per ottimizzare il vostro sito web e rimanere all'avanguardia nel gioco SEO. Oggi presentiamo quindi un elenco completo di crawler che può essere utile ai webmaster e ai professionisti SEO.

Contenuti

ToggleConoscere i crawler web

I web crawler, noti anche come web crawler bot, sono programmi automatizzati che si muovono avanti e indietro nel web, organizzando i contenuti per l'ottimizzazione dei motori di ricerca, la raccolta di dati e il monitoraggio.

Sono essenziali per l'indicizzazione delle pagine web e i motori di ricerca come Google, Bing e altri utilizzano un token dell'agente utente per identificarsi quando accedono ai siti web.

Comprendere il funzionamento dei vari web crawler attraverso un elenco completo può aiutare a ottimizzare le pagine di destinazione per i motori di ricerca.

Per saperne di più: Che cos'è un crawler web?

Come funzionano i web crawler

I crawler web scansionano sistematicamente le pagine web e indicizzano i dati per memorizzarli nell'indice di un motore di ricerca e recuperarli in risposta alle query di ricerca degli utenti. Segue i link da una pagina all'altra e aderisce al protocollo robots.txt, aiutando i crawler dei motori di ricerca a sapere a quali URL può accedere il vostro sito.

Gli sviluppatori o gli addetti al marketing possono specificare nel robots.txt del loro sito se approvare o negare determinati crawler in base al token del loro user agent.

La comprensione del processo di crawling può rendere il vostro sito web più accessibile e visibile ai motori di ricerca come Google e Bing. Questa conoscenza può in definitiva migliorare il posizionamento e la visibilità del vostro sito web nei risultati di ricerca.

Tipi di Web Crawler

Esistono tre tipi principali di web crawler:

- I crawler generici, noti anche come web crawler o spider, esplorano sistematicamente le pagine web per raccogliere dati da indicizzare sui motori di ricerca. I motori di ricerca utilizzano queste informazioni per classificare e presentare i risultati della ricerca.

- I crawler focalizzati si rivolgono a tipi specifici di contenuti o siti web. Sono progettati per raccogliere informazioni su un particolare argomento o dominio.

- I crawler incrementali effettuano il crawling solo delle pagine web che sono state aggiornate dall'ultimo crawling. In questo modo possono raccogliere in modo efficiente i contenuti nuovi o modificati, senza dover ricansionare l'intero sito web.

I crawler focalizzati, invece, raccolgono le pagine web che aderiscono a una proprietà o a un argomento specifico, dando priorità strategica alla frontiera del crawling e mantenendo una raccolta di pagine rilevanti.

I crawler incrementali rivisitano gli URL e ricansionano gli URL esistenti per mantenere aggiornati i dati crawlati, il che li rende ideali per gli scenari che richiedono dati aggiornati e coerenti.

Correlato: Come funziona il motore di ricerca - Crawling, indicizzazione e ranking?

I 14 migliori crawler web da conoscere nel 2023

Questo elenco completo di crawler illustra i crawler web più comuni, evidenziando il loro ruolo nell'indicizzazione dei motori di ricerca, nella raccolta dei dati e nell'analisi. Questi crawler includono:

- Googlebot

- Bingbot

- Bot Yandex

- Google Bard

- Openai ChatGPT

- Facebook Crawler

- Twitterbot

- Pinterestbot

- AhrefsBot

- SemrushBot

- Campagna Crawler di Moz Rogerbot

- Apache Nutch

- Rana urlante

- HTTrack

Esploreremo ciascuno di essi nell'elenco dei crawler, concentrandoci sui loro ruoli e funzionalità unici.

Googlebot

Googlebot, noto anche come user agent Googlebot, è il crawler principale di Google. È responsabile dell'indicizzazione e del rendering delle pagine per il motore di ricerca. Esegue il crawling dei siti web di Google seguendo i link, analizzando le pagine web e rispettando le regole di robots.txt, assicurando che il contenuto del sito web sia accessibile al motore di ricerca di Google.

Conoscere Googlebot è importante perché il suo processo di crawling può migliorare notevolmente il posizionamento e la visibilità del vostro sito web sui motori di ricerca.

Bingbot

Bingbot è il web crawler di Microsoft per il motore di ricerca Bing, con un approccio mobile-first all'indicizzazione. Si concentra sull'indicizzazione della versione mobile dei siti web, enfatizzando i contenuti mobile-friendly nei risultati di ricerca per soddisfare la natura mobile-centrica della navigazione moderna.

È simile a Googlebot e il principale motore di ricerca cinese è un crawler cruciale per coloro che vogliono che i loro contenuti siano reperibili su più motori di ricerca.

Bot Yandex

Yandex Bot è il web crawler del motore di ricerca russo Yandex, che privilegia la scrittura cirillica e i contenuti in lingua russa. È responsabile del crawling e dell'indicizzazione di siti web prevalentemente in russo, per soddisfare le esigenze specifiche del pubblico di lingua russa.

Yandex Bot è un web crawler fondamentale per chi si rivolge al mercato russo per ottimizzare i propri contenuti.

Google Bard

Google Bard è un web crawler per le API generative di Google Bard e Vertex AI, che aiuta gli editori web a gestire i miglioramenti del sito. Può aiutare gli editori web a gestire i miglioramenti del sito offrendo risposte più precise, integrandosi con le app e i servizi di Google e consentendo agli editori di regolare i dati di formazione dell'IA.

Migliora la visibilità dei contenuti di origine e fornisce citazioni autentiche nelle risposte, rendendolo uno strumento prezioso per gli editori web che cercano di ottimizzare i loro contenuti.

Openai ChatGPT

Openai ChatGPT è un web crawler utilizzato da OpenAI per addestrare e migliorare i suoi modelli linguistici. GPTBot raccoglie i dati disponibili pubblicamente dai siti web per migliorare i modelli di intelligenza artificiale come GPT-4.

Il web crawler di Openai ChatGPT affina in modo significativo le capacità dell'IA, garantendo un'esperienza utente superiore e risposte più accurate da parte del chatbot guidato dall'IA.

Crawler dei social media

I crawler dei social media migliorano l'esperienza e il coinvolgimento degli utenti su varie piattaforme. Indicizzano e visualizzano i contenuti condivisi su piattaforme come Facebook, Twitter e Pinterest, fornendo agli utenti un'anteprima visivamente accattivante e informativa dei contenuti web.

Ora parleremo di tre importanti crawler di social media: Facebook Crawler, Twitterbot e Pinterestbot.

Facebook Crawler

Facebook Crawler raccoglie le informazioni sui siti web condivisi sulla piattaforma e genera ricche anteprime, tra cui un titolo, una breve descrizione e un'immagine in miniatura. In questo modo gli utenti possono avere una rapida visione del contenuto condiviso prima di cliccare sul link, migliorando l'esperienza dell'utente e incoraggiando il coinvolgimento con il contenuto condiviso.

Facebook Crawler ottimizza i contenuti condivisi per la piattaforma, offrendo agli utenti un'esperienza di navigazione visivamente coinvolgente e ricca di informazioni.

Twitterbot

Twitterbot, il web crawler di Twitter, indicizza e visualizza gli URL condivisi per mostrare le anteprime dei contenuti web sulla piattaforma. Generando schede di anteprima con titoli, descrizioni e immagini, Twitterbot fornisce agli utenti un'istantanea dei contenuti condivisi, incoraggiando il coinvolgimento e l'interazione degli utenti.

Twitterbot ottimizza i contenuti per la piattaforma Twitter, rendendo più facile per gli utenti scoprire e interagire con i contenuti condivisi.

Pinterestbot

Si tratta di un web crawler per la piattaforma sociale visuale, che si concentra sull'indicizzazione di immagini e contenuti da visualizzare sulla piattaforma. Pinterestbot esegue il crawling e l'indicizzazione delle immagini, consentendo agli utenti di scoprire e salvare ispirazioni visive attraverso i pin e le bacheche.

La sua funzione principale è quella di fornire agli utenti un'esperienza di navigazione visivamente straordinaria e organizzata, che consenta loro di esplorare e di impegnarsi con i contenuti adatti ai loro interessi.

Elenco di strumenti SEO Crawler

I crawler di strumenti SEO sono essenziali per la raccolta di dati per l'analisi e l'ottimizzazione delle prestazioni dei siti web in varie piattaforme SEO. Questi crawler forniscono preziose informazioni sulla struttura dei siti web, sui backlink e sul coinvolgimento degli utenti, aiutando i proprietari dei siti web e gli addetti al marketing a prendere decisioni informate per migliorare la loro presenza online.

Ora esploreremo tre popolari crawler di strumenti SEO: AhrefsBot, SemrushBot e Campaign Crawler Rogerbot di Moz.

AhrefsBot

AhrefsBot è un crawler web che indicizza i link per il software SEO Ahrefs. Ogni giorno visita 6 miliardi di siti web, il che lo rende il secondo crawler più attivo dopo Googlebot.

AhrefsBot effettua il crawling dei siti web per raccogliere informazioni su backlink, parole chiave e altri fattori SEO. Viene utilizzato per informare le decisioni di ottimizzazione.

AhrefsBot è uno strumento prezioso per chi vuole migliorare il posizionamento e la visibilità del proprio sito web sui motori di ricerca. Tra questi ci sono anche i proprietari di siti web, i professionisti SEO e gli esperti di marketing.

SemrushBot

SemrushBot è un bot web crawler impiegato da Semrush, un importante fornitore di software SEO. Per acquisire e catalogare i dati dei siti web per l'utilizzo da parte dei clienti sulla propria piattaforma. Genera un elenco di URL di pagine web, le visita e memorizza determinati collegamenti ipertestuali per le visite future.

I dati di SemrushBot sono utilizzati in diversi strumenti Semrush, tra cui:

- Motore di ricerca pubblico di backlink

- Strumento di verifica del sito

- Strumento di verifica dei backlink

- Strumento di link building

- Assistente di scrittura

Questi strumenti forniscono indicazioni preziose per ottimizzare le prestazioni del sito web e le strategie SEO.

Campagna Crawler di Moz Rogerbot

Moz's Campaign Crawler Rogerbot è un web crawler progettato specificamente per le verifiche dei siti della campagna Moz Pro. È fornito dal principale sito SEO, Moz. Raccoglie i contenuti per le verifiche della Campagna Moz Pro e segue le regole di robots.txt per garantire la conformità alle preferenze dei proprietari dei siti web.

Rogerbot è uno strumento prezioso per i proprietari di siti web e gli operatori di marketing che desiderano migliorare il posizionamento e la visibilità del proprio sito sui motori di ricerca. Utilizza verifiche complete del sito e strategie di ottimizzazione basate sui dati.

Correlato: SEO ottimale su WordPress nel 2024: Una guida completa

Crawler open source

I crawler open-source offrono flessibilità e scalabilità per il crawling di siti web specifici o per il crawling di Internet su larga scala. Questi crawler possono essere personalizzati per adattarsi a esigenze specifiche. Ciò li rende una risorsa preziosa per gli sviluppatori web e i professionisti SEO che desiderano ottimizzare le prestazioni del proprio sito web.

Ora approfondiremo tre crawler open-source: Apache Nutch, Screaming Frog e HTTrack.

Apache Nutch

- un web crawler open-source flessibile e scalabile

- utilizzato per il crawling di siti web specifici o dell'intero Internet

- basato sulle strutture dati di Apache Hadoop

- possono essere configurati in modo dettagliato.

Apache Nutch è ideale per gli sviluppatori web e i professionisti SEO che necessitano di un crawler web personalizzabile per soddisfare le loro esigenze specifiche, sia che si tratti di crawling di un particolare sito web sia che si tratti di crawling di Internet su larga scala.

Rana urlante

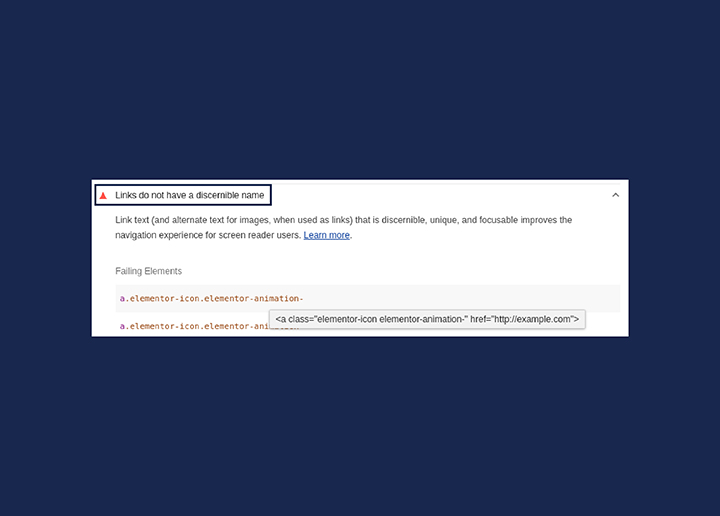

Screaming Frog è uno strumento desktop per il crawling dei siti web dal punto di vista SEO, che presenta gli elementi in loco in schede per l'analisi e il filtraggio in tempo reale. È rinomato per la sua interfaccia facile da usare e per la rapidità nel produrre risultati tecnici che massimizzano i crawling di Google.

Screaming Frog è una risorsa fondamentale per gli sviluppatori web e i professionisti SEO che desiderano migliorare le prestazioni del proprio sito web utilizzando verifiche complete del sito e strategie di ottimizzazione basate sui dati.

HTTrack

HTTrack è un freeware in grado di scaricare e fare il mirroring di siti web, con supporto per più sistemi e molte funzioni. Funziona impiegando un web crawler per recuperare i file del sito web e organizzarli in una struttura che preserva la struttura dei collegamenti relativi del sito originale.

In questo modo gli utenti possono navigare il sito web scaricato offline utilizzando qualsiasi browser web. HTTrack è uno strumento prezioso per i proprietari di siti web e gli operatori di marketing che desiderano creare una copia locale di un sito web per la navigazione offline o la replica.

Proteggere il proprio sito web da crawler maligni

Proteggere il vostro sito web da crawler dannosi è essenziale per prevenire frodi, attacchi e furti di informazioni. Identificare e bloccare questi crawler dannosi può salvaguardare i contenuti, i dati degli utenti e la presenza online del vostro sito web. Rende l'esperienza di navigazione dei visitatori sicura e protetta.

Ora discuteremo le tecniche per identificare i crawler dannosi e i metodi per bloccare il loro accesso al vostro sito web.

Identificare i crawler dannosi

L'identificazione di crawler dannosi comporta il controllo degli agenti utente, compresa la stringa completa dell'agente utente, la stringa dell'agente utente desktop, la stringa dell'agente utente e gli indirizzi IP nei record del sito.

L'analisi di queste caratteristiche consente di distinguere i crawler legittimi da quelli dannosi. Questo vi aiuta a prendere le misure appropriate per proteggere il vostro sito web da potenziali minacce.

Il monitoraggio regolare dei registri di accesso del vostro sito web e l'implementazione di misure di sicurezza possono contribuire a mantenere un ambiente online sicuro per i vostri utenti.

Tecniche di blocco

Tecniche come la regolazione dei permessi tramite robots.txt e l'implementazione di misure di sicurezza come i firewall per applicazioni web (WAF) e le reti di distribuzione dei contenuti (CDN) possono bloccare i crawler dannosi.

L'utilizzo della direttiva "Disallow" seguita dal nome dell'user-agent del crawler che si desidera bloccare nel file robots.txt è un modo efficace per bloccare determinati crawler web.

Inoltre, l'implementazione di un WAF può proteggere il sito web da crawler maligni filtrando il traffico prima che raggiunga il sito, mentre un CDN può proteggere un sito web da crawler maligni instradando le richieste al server più vicino alla posizione dell'utente, riducendo il rischio che i bot attacchino il sito web.

L'impiego di queste tecniche di blocco può contribuire a salvaguardare il vostro sito web da crawler dannosi e a garantire un'esperienza di navigazione sicura ai vostri visitatori.

Correlato: I migliori fornitori di servizi di sicurezza per WordPress del 2023

Volete migliorare la SEO del vostro sito?

Ottenete tutte le risposte con un audit SEO dettagliato del vostro sito web e tornate nei risultati di ricerca.

Sintesi

In conclusione, i web crawler svolgono un ruolo fondamentale nel panorama digitale, in quanto sono responsabili dell'indicizzazione delle pagine web, della raccolta dei dati e della possibilità per i motori di ricerca di fornire risultati di qualità.

Conoscere i diversi tipi di web crawler e le loro funzioni può fornire preziose indicazioni per ottimizzare il vostro sito web e rimanere all'avanguardia nel mondo digitale. Implementando misure di sicurezza e tecniche di blocco adeguate, potete proteggere il vostro sito web da crawler dannosi e mantenere un ambiente online sicuro e protetto per i vostri utenti.

Domande frequenti

Esempi di web crawler sono Googlebot (versione desktop e mobile), Bingbot, DuckDuckBot, Yahoo Slurp, YandexBot, Baiduspider ed ExaBot.

Un motore di ricerca crawler, noto anche come spider, robot o bot, è un programma automatico che sfoglia sistematicamente le pagine web per indicizzarle per i motori di ricerca.

I crawler sono programmi informatici automatizzati che effettuano ricerche su Internet, spesso definiti "robot". I diversi crawler sono specializzati nello scraping, nell'indicizzazione e nella ricerca di link. Utilizzano questi dati per compilare le pagine web per i risultati di ricerca.

I crawler dei social media aiutano a indicizzare e visualizzare i contenuti su più piattaforme, migliorando l'esperienza dell'utente e aumentando il coinvolgimento.

Implementate i firewall per applicazioni web (WAF) e le reti di distribuzione dei contenuti (CDN) per proteggere il vostro sito web da crawler maligni.