I Web crawler, impiegati dai motori di ricerca e spesso chiamati spider o bot, hanno il compito di scaricare e indicizzare i contenuti su Internet. Un bot come questo è progettato per conoscere il contenuto di (quasi) tutti i siti web su Internet, in modo da garantire che le informazioni pertinenti possano essere recuperate quando necessario.

Nella maggior parte dei casi, sono i motori di ricerca a gestire questi bot e a occuparsi della loro manutenzione. Quando un utente effettua una ricerca con Google o Bing, viene prodotto un elenco di siti web che vengono restituiti come risultati (o con un altro motore di ricerca).

Un modo per pensare a un bot web crawler è quello di un individuo il cui compito è cercare tra tutti i libri di una biblioteca non organizzata per compilare un catalogo di carte. Questo catalogo è a disposizione di tutti coloro che visitano la biblioteca e può essere utilizzato per trovare rapidamente e facilmente le informazioni desiderate.

Come funzionano i web crawler?

Internet acquisisce continuamente nuove capacità ed espande la sua sfera operativa. I Web crawler bot iniziano il loro lavoro da un seme, che è semplicemente un elenco di URL che già conoscono. Da questo seme traggono il punto di partenza per il loro lavoro. Questo perché è fisicamente impossibile conoscere l'intero numero di siti web disponibili su Internet. Iniziano a fare il crawling dei siti web a cui si può accedere utilizzando gli URL forniti. Continuano a scansionare queste pagine web fino a quando non scoprono collegamenti ad altri URL; a quel punto, aggiungono queste pagine web all'elenco dei domini da scansionare successivamente.

È possibile che questo processo si protragga per un tempo pressoché illimitato, dal momento che sono molti i siti web indicizzati a scopo di ricerca. I web crawler considerano anche altri fattori che indicano la probabilità che la pagina contenga informazioni significative. La maggior parte dei web crawler non è stata progettata per effettuare il crawling dell'intera porzione pubblica di Internet. Decidono invece quali siti scansionare per primi prendendo in considerazione diverse caratteristiche come queste.

Un motore di ricerca deve aver indicizzato un sito a cui fanno riferimento molte altre pagine web e che ha un gran numero di visite. Questo perché è più probabile che una pagina web di questo tipo contenga contenuti di alta qualità e autorevolezza. Questa situazione è paragonabile al modo in cui una biblioteca si assicura di avere un numero sufficiente di copie di un libro spesso preso in prestito da molti clienti.

Indagine sui siti web visitati in precedenza

Le informazioni che si possono trovare sul World Wide Web vengono continuamente aggiornate, rimosse o spostate su altri siti web. I web crawler devono visitare frequentemente i siti che indicizzano per garantire che i loro database includano la versione più aggiornata del materiale.

All'interno degli algoritmi specializzati utilizzati dagli spider bot dei diversi motori di ricerca, questi fattori hanno un diverso grado di importanza. Tuttavia, l'obiettivo finale di tutti i web crawler è lo stesso: scaricare e indicizzare i contenuti dei siti web, ma i web crawler impiegati dai vari motori di ricerca si comportano in modo leggermente diverso.

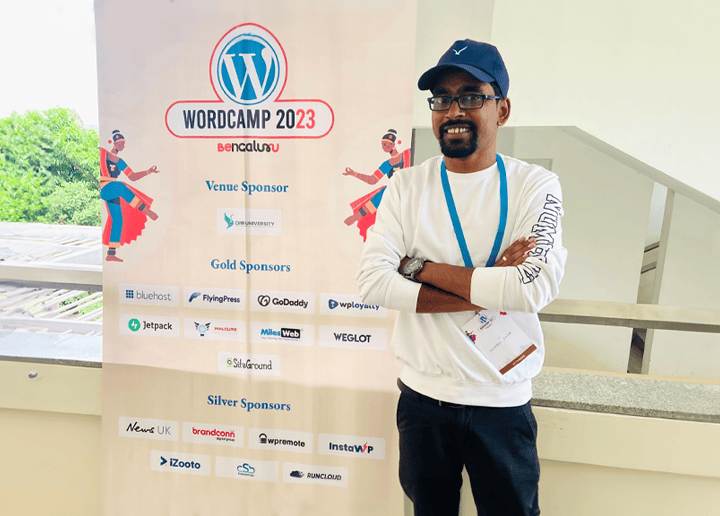

Per altri articoli di questo tipo, consultare Seahawkmedia .